Retour sur la séance du forum des archivistes genevois par Emmanuel Ducry et Anouk Dunant Gonzenbach

Le forum des archivistes genevois a présenté le 11 septembre 2017 une séance consacrée à la norme « Records in Context » (RIC). Dans une première partie, Jean-Daniel Zeller a rappelé les principes de cette norme.

Records in Context – RIC

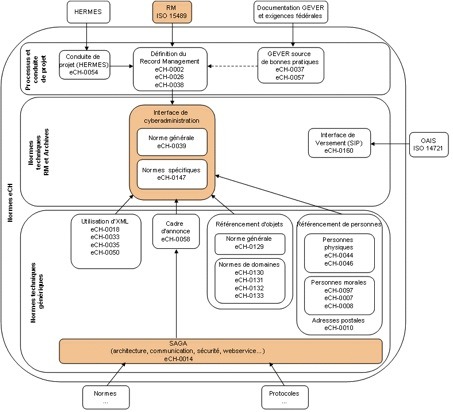

RIC est une nouvelle norme archivistique regroupant les normes ISAD-G, ISAAR, ISAF et ISDIAH.

Elle émane du groupe d’experts EGAD (Expert Group on Archival Description), mandaté en 2012 par le comité international des archives (ICA) pour fusionner ces quatre normes. Pour rappel :

– ISAD-G (General International Standard Archival Description) a pour objet la description des fonds;

– ISAAR (CPF) (International Standard Archival Authority Records-Corporate Bodies, Persons, and Families) a pour objet la description des producteurs;

– ISDF (International Standard for Describing Functions) a pour objet la description des fonctions;

– ISDIAH (International Standard for Describing Institutions with Archival Holdings) a pour objet la description des services conservant les fonds.

La norme qui a résulté des travaux de l’EGAD porte le nom de Records in Context (RiC).

Deux éléments se cachent sous ce terme:

– un modèle conceptuel (la norme) : Record in Context Conceptual Model (RiC-CM),

– une ontologie : Record in Context Ontology (RiC-O), à savoir la grammaire permettant de mettre en pratique le modèle conceptuel.

On peut relever que le travail sur une ontologie montre d’emblée que les réflexions du groupe se placent dans le contexte du web sémantique.

Le groupe EGAD a constaté que si ISAD-G a eu une profonde influence sur la profession au niveau international et qu’ISAAR a connu quelques utilisations ici et là, ISDF et ISDIAH n’ont quant à eux eu aucun écho ou presque. Par conséquent, la manière d’organiser les fonds selon une structure tectonique (fonds, série, sous-série, sous-sous-série, etc.) respectant le principe de provenance reste au cœur du modèle. Ainsi, l’on retrouve dans RiC l’ensemble d’ISAD complété par des éléments provenant d’SAAR, ISDF et ISDIAH.

Toutefois, si l’on y retrouve l’organisation hiérarchique d’ISAD, elle est étendue sous forme d’un réseau. Un élément d’un fonds peut être lié à un autre fonds, une fonction, un producteur, un utilisateur à des droits , et pas forcément le même que celui de l’élément d’à côté. Ce qui veut dire que le modèle permet de rester à une stricte description du type ISAD pour assurer la compatibilité avec l’existant (il faudra cependant traduire les anciens fichiers ISAD dans le nouveaux langage de description), ou de l’enrichir et de le développer pour le faire évoluer vers le réseau.

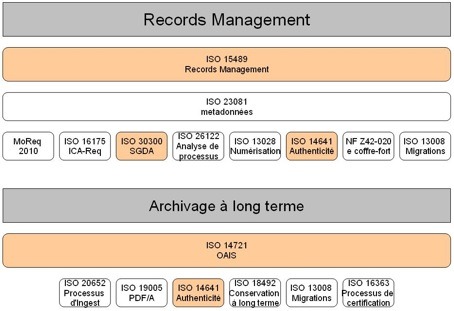

On trouve dans RIC la volonté de se mettre en phase avec les professions qui nous entourent et que cette norme soit utilisable par les archivistes et les Record Manager, une collaboration rendue de plus en plus nécessaire par l’archivage électronique. Les exigences de l’archivage électronique sont donc aussi un élément fondamental pris en compte dans cette révision. On trouve également la volonté de faciliter l’interface avec les normes existant dans les autres institutions patrimoniales telles que les bibliothèques ou les musées de façon à faciliter les échanges de données, les développements informatiques, etc. S’il n’est pas possible d’être totalement cohérent avec l’univers des bibliothécaires (FRBR) qui utilise une autre logique, il y a des éléments, comme les descriptions d’auteurs, qu’il est possible de partager.

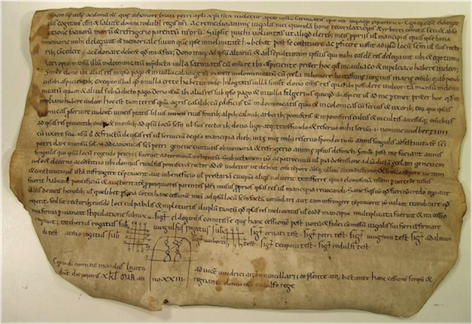

Enfin, si les RiC sont prévus pour gérer la masse de données issues de l’archivage électronique, ils sont aussi pensés pour pouvoir être utilisés pour des descriptions très détaillées d’une pièce ou des archives d’un individu. Par-là, il y a une volonté d’ouvrir la norme vers les utilisateurs des archives pour des utilisations autres que proprement archivistiques.

En résumé il y a une volonté d’intégrer l’ensemble des normes archivistiques existantes et de faciliter la connexion de cette norme avec des contextes d’utilisation et des normes voisines qui peuvent être utilisées dans les musées, les bibliothèques ou par les chercheurs.

Actuellement, la norme RIC est un draft en consultation; l’ontologie qui permettra son utilisation n’est pas terminée.

Le Matterhorn RDF Data Model : implémentation des modèles d’information OAIS et RiC dans le cadre des technologies sémantiques

La seconde partie de la séance a été consacrée à la présentation par Alain Dubois, Archiviste d’Etat du canton du Valais et Tobias Wildi, Direction de Docuteam, de la transformation de leur Matterhorn Mets Profile dans une forme adaptée au web sémantique, le Matterhorn RDF Data Motel. Une forme parallèle au RIC en somme, puisque ce dernier n’est pas encore finalisé. (Le Matterhon Mets Profile est un modèle de boîte électronique qui a pour principal intérêt d’être basé sur un emboîtement de modèle de métadonnée (METS + PREMIS + ISAD) souvent utilisé au niveau international.) Le powerpoint de la présentation se trouve ici.

Cette séance du forum a remporté un grand succès car, au-delà des frontières cantonales, elle a réuni une cinquantaine d’archivistes genevois, vaudois, neuchâtelois et bernois. On constate donc le grand intérêt pour notre profession à se tenir au courant des derniers développements. En revanche, on ressent une certaine peur devant la complexité de l’affaire.

Nous nous faisons la réflexion que si tout le monde sent que le web sémantique est l’avenir, il s’agit plus du web d’après-demain que de demain. En effet, le web de demain, c’est le Linked Open Data (LOD), ou web des données.